Si las conclusiones del estudio publicado por Harvard Business Review son ciertas, estamos ante una tendencia preocupante.

Entre los 3 principales usos de la IA generativa en 2025, no encontramos tareas empresariales ni creativas. Lo que aparece es:

1º Terapia o acompañamiento emocional

2º Encontrar propósito vital

3º Asistencia personal emocional

Sí, cada vez más personas sustituyen a su psicólogo por una IA. ¿Los resultados? En muchos casos, nefastos.

Ya existen modelos centrados exclusivamente en ofrecer esta clase de «terapia digital»:

🧠 Terapeuta IA, TerapIA, Brain, Panda (Earkik), FeelBetterBot, Abby o La IA Psicóloga.

🔍 El filósofo Mark Coeckelbergh lo advierte:

«Este tipo de relaciones generan conexiones humanas más pobres y abren la puerta a una mayor manipulación emocional, alimentada por el volumen creciente de datos sensibles que facilitamos a estos sistemas.»

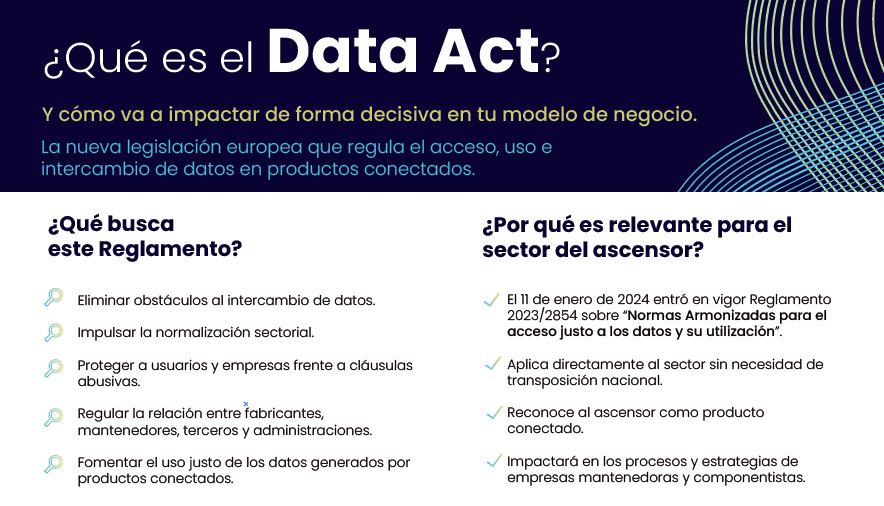

🧑⚖️ ¿Y EL MARCO LEGAL?

Este fenómeno ya plantea múltiples conflictos jurídicos:

* Reglamento de IA de la UE (Reglamento (UE) 2024/1689): clasifica como alto riesgo a los sistemas que ofrecen apoyo psicológico o emocional, exigiendo controles estrictos de seguridad, transparencia y supervisión humana.

* Reglamento General de Protección de Datos: el tratamiento de datos sobre salud mental exige consentimiento explícito y garantías reforzadas.

* Código Deontológico de Psicólogos y normativas estatales (como la Ley 44/2003 en España): regulan quién puede ejercer funciones terapéuticas, lo que puede entrar en conflicto con estos modelos.

Además, ¿quién asume la responsabilidad si hay un daño psicológico real? ¿El desarrollador del modelo, el proveedor del servicio, o el usuario que lo interpreta como herramienta terapéutica?

🤔 La pregunta no es si estas herramientas pueden ayudarnos. La pregunta es: ¿estamos preparados para que un algoritmo gestione nuestra salud mental?

Para pensar.